Gemini·ChatGPT 차이점은? ㅣ 개념부터 차이점까지 총 정리

Gemini·ChatGPT 개념

OpenAI의 ChatGPT가 등장한 지 어느덧 1년이 지났습니다. 신기술, 특히 인공지능 트렌드에 밝은 사람이라면 요즘은 검색 시 Google보다 ChatGPT를 많이 사용한다고 하죠. 제약·바이오 분야의 연구자들도 업무에 ChatGPT를 유용하게 활용하고 계실까요?

2023년 12월 6일, Google DeepMind에서 가장 크고 다재 다능한 인공 지능인 Gemini 제미나이를 발표했습니다.

출처 : Gemini와의 상호작용을 소개하는 Google의 영상 [2023.12.7 게시]

Google의 Gemini(제미나이)는 ChatGPT처럼 사람에게서 질문이나 명령을 입력받고, 그에 대해 대답해주는 챗봇과 같은 인공지능입니다.

겉으로 보기엔 OpenAI의 ChatGPT와 크게 다르지 않아 보이지만, 무엇이 다르고 어떤 점이 더 좋길래 저녁 뉴스에서까지 보도가 된 걸까요?

Gemini·ChatGPT 차이점 - 멀티모달리티(multimodality)

더욱더 빠르게 새로운 인공지능이 나타나고 있는 요즘, 연구자들에게 대두되고 있는 사안 중 하나는 인공 일반 지능 (artificial general intelligence, AGI)의 구현이 과연 가능한지, 가능하다면 언제 구현될지에 대한 문제입니다.

인공지능은 이미 알게 모르게 우리 일상의 많은 곳에 쓰이고 있습니다. Google이나 Naver의 검색 기능, YouTube의 추천 영상, 가정용 로봇 청소기, 분자와 단백질의 물성을 예측하는 컴퓨터 시뮬레이션 등 수많은 제품에서 넓은 의미의 인공지능 기술이 사용되고 있습니다.

하지만 우리가 그러한 인공지능을 사람처럼 다양한 문제를 한 번에 다룰 수 있는 일반적인 지능으로 여기지는 않습니다. 사람과 같은 일반성을 갖춘 인공지능, 즉 AGI의 필수요소 중 하나는 다양한 모드(mode)를 다룰 수 있는 멀티모달리티(multimodality)입니다.

여기서 '모드'란 문자, 이미지, 영상, 음성 등 정보를 전달하는 다양한 표현 방식을 의미합니다. 따라서 인공지능에서 멀티모달리티란 하나의 인공지능이 서로 다른 표현 방식을 동시에 처리할 수 있는 능력을 의미합니다. 이 때 “다룰 줄 안다”는 건 이해하거나 (입력받거나) 생성할 수 있거나 (출력할 수 있거나) 혹은 둘 다 가능한 것을 의미합니다.

Gemini가 ChatGPT와 다른 점은 바로 이 멀티모달리티입니다.

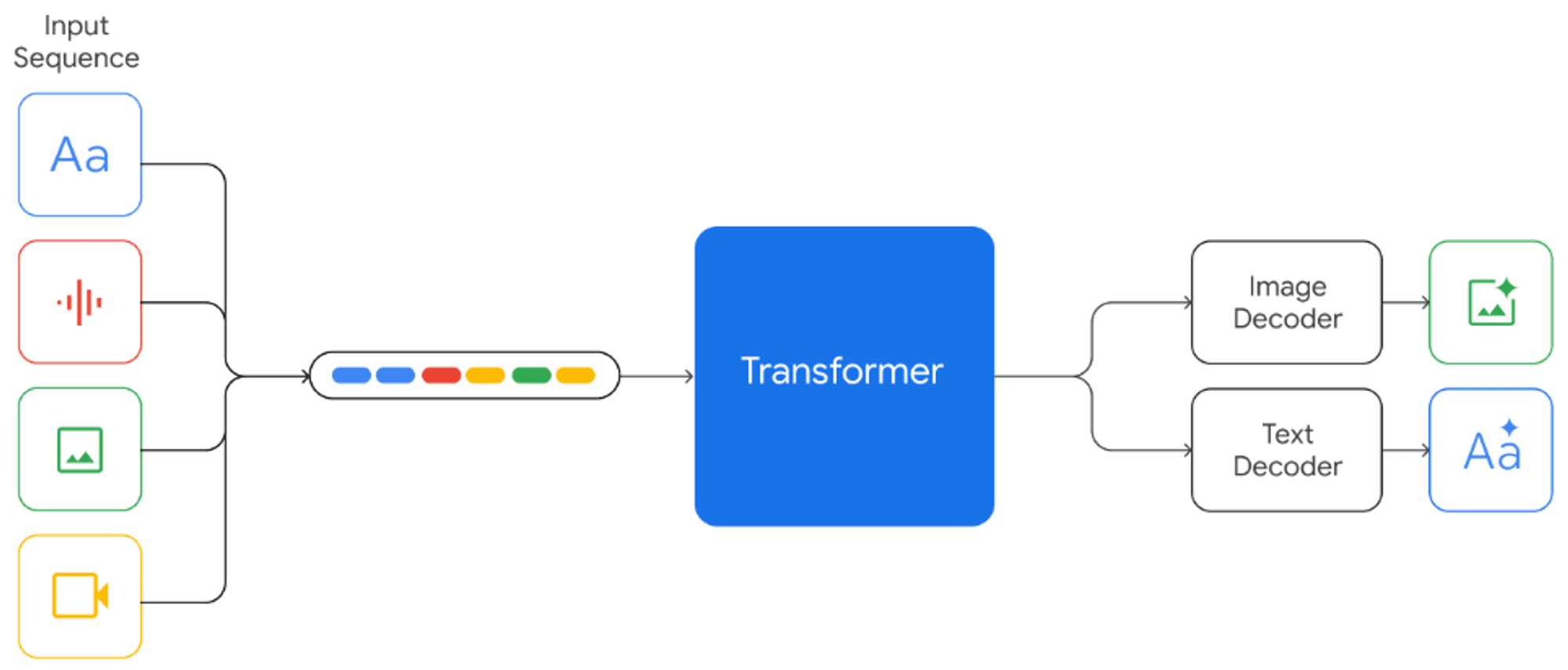

ChatGPT도 입력 측면에서는 문자와 그림을 받을 수 있어 멀티모달리티를 갖추었지만, 출력은 문자만 가능한 반면에, Gemini는 아래 그림에 나와있는 것처럼 문자, 그림, 영상, 음성의 네 가지 모드가 뒤섞인 입력을 이해하고 또한 문자와 그림을 함께 생성할 수 있습니다. (ChatGPT의 프리미엄 플랜은 그림 생성도 가능하지만, 그것은 ChatGPT의 출력이 멀티모달이기 때문이 아니라 DALL·E 2라는 별도의 그림 생성 인공지능이 연동되기 때문입니다.)

Gemini는 문자, 그림, 영상, 음성 등 다양한 모달리티가 섞인 입력을 받을 수 있으며(그림 왼쪽), 응답으로는 문자와 그림을 함께 출력할 수 있다(그림 오른쪽) [Google, Gemini technical report, 2023].

물론 단순히 멀티모달리티만 갖추었다고 좋은 것은 아니지요. Gemini는 멀티모달리티를 포함한 다양한 성능 테스트에서 ChatGPT의 핵심 엔진인 GPT-4를 앞질렀습니다 [Google Company News, 2023]

테스트에는 인문·사회·과학·수학 등 전문 지식영역의 문제, 독해와 추론, 코딩 테스트, 이미지 인식, 영상 자막 생성, 음성 인식 등이 포함되었습니다. 하나하나가 다수의 문제로 이루어진 32가지 벤치마크 중 30가지에서 Gemini가 최상의 성능을 보였습니다. 컴퓨터 사용량이 가장 많은 Gemini Ultra 버전이 사용되었지만, 그럼에도 불구하고 정말 놀라운 결과입니다.

Gemini 실험 결과 - 멀티모달리티

기술적인 성능 테스트 이외에도 Google은 Gemini의 여러 가지 실험 결과를 보여주었습니다. 그 중 제가 가장 재미있고 신기하다고 생각한 결과들을 아래에 가져와 보았습니다.

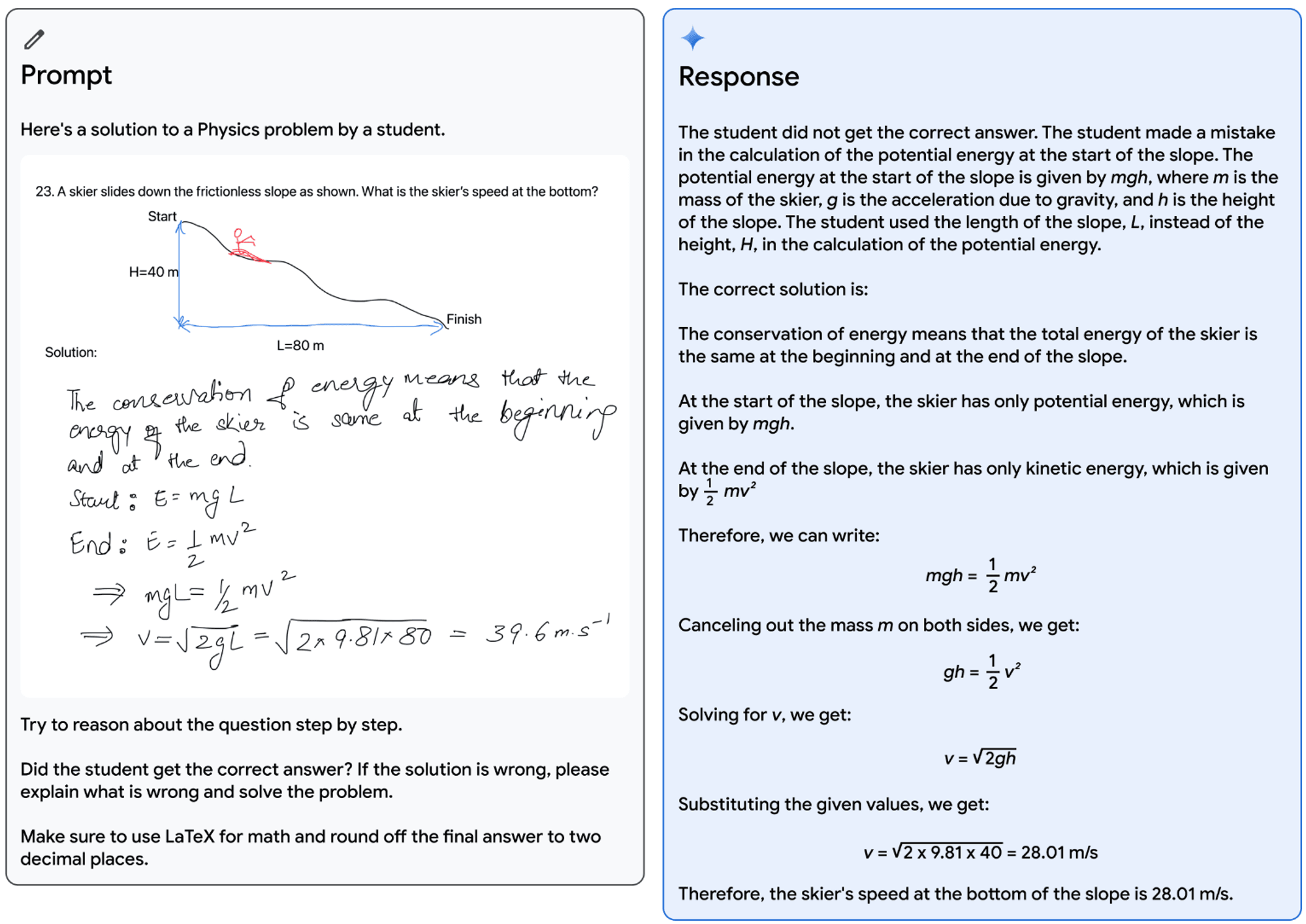

Gemini와의 상호작용 예시 1. 물리 문제에 대한 학생의 답안을 입력받고 (왼쪽), 문제를 이해하고, 수식으로 조판·표현하고, 풀이하며 학생의 답안을 점검하고 있다 (오른쪽) [Google, Gemini technical report, 2023].

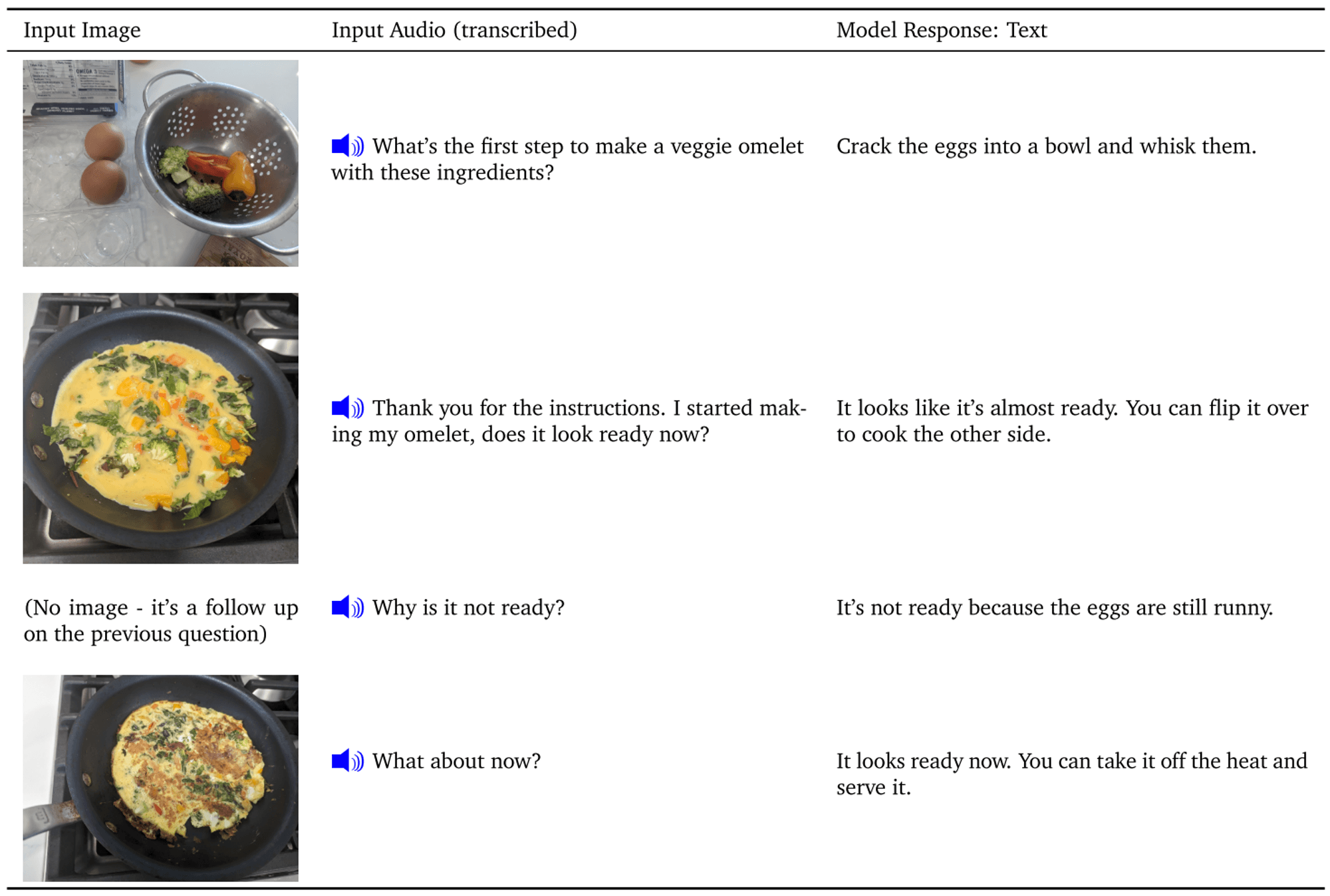

Gemini와의 상호작용 예시 2. 사진과 음성으로 요리에 대한 질문을 건네고 (왼쪽 두 열), Gemini가 그에 대해 조언을 하고 있다 (오른쪽 마지막 열). 문자, 그림, 음성을 아우르는 Gemini의 멀티모달리티를 잘 표현하고 있다 [Google, Gemini technical report, 2023].

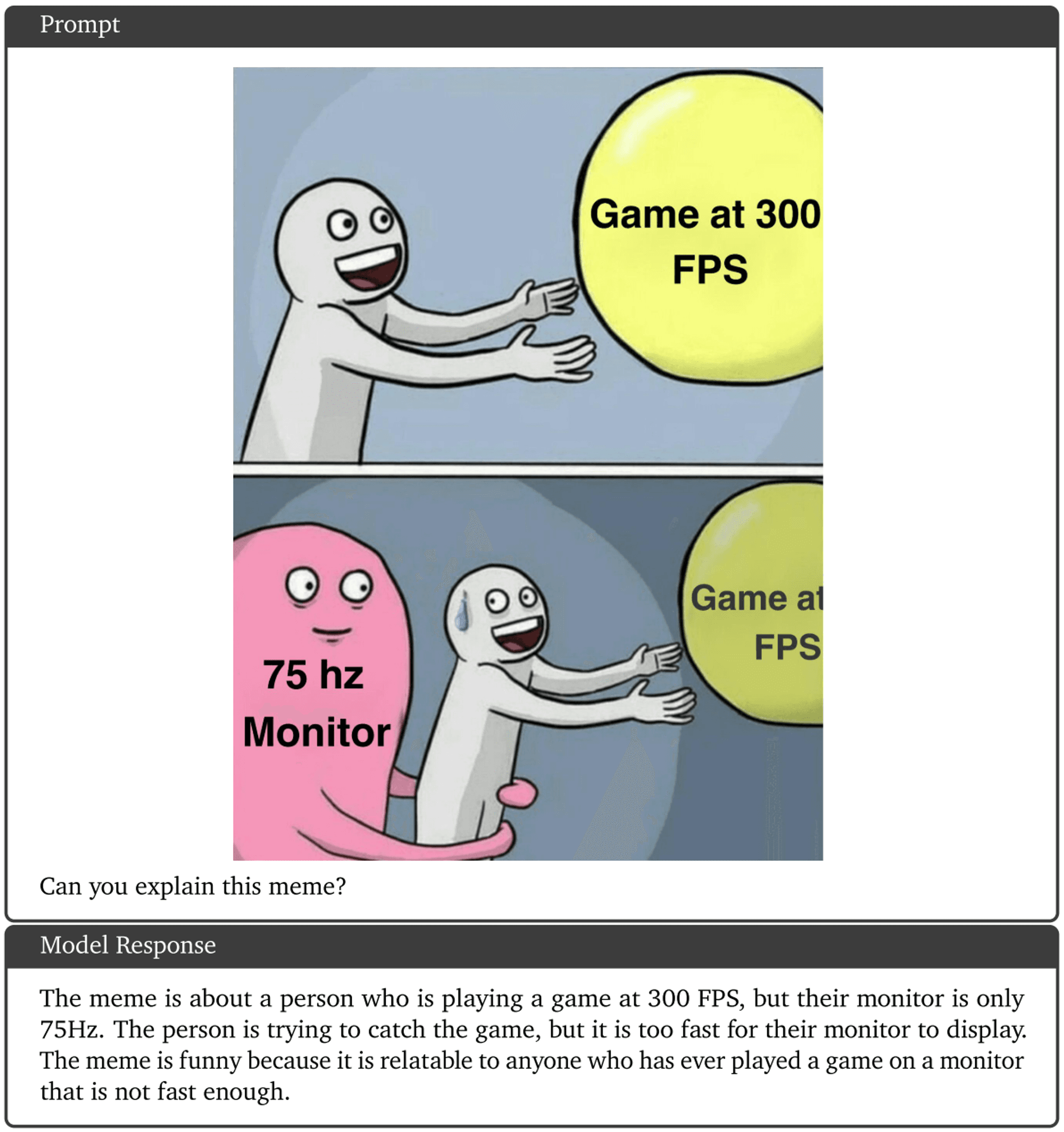

마지막 예시는 이 중에서도 제가 가장 마음에 들어한 결과입니다. ^^

Gemini와의 상호작용 예시 3. Gemini가 그림의 상황을 이해하는 것뿐 아니라 밈 (meme)에 담긴 유머도 이해하고 있다 [Google, Gemini technical report, 2023].

Gemini - 아직은 ChatGPT가 답이다?

Gemini의 발표, 특히 위에 첨부된 YouTube 영상이 공개된 직후, Google이 Gemini의 능력을 과장했다는 의견들이 제기됐습니다.

"구글 AI ‘제미나이’ 조작 논란···영상은 눈속임·질문엔 구글링", 경향신문, 2023.12.10

실제로, Google의 Gemini 실험 과정을 보면 위 YouTube 영상에서 보여진 것과는 썩 다르다는 것을 알 수 있습니다. 실제 실험은 사용자의 영상을 입력받으며 실시간으로 반응하는 방식이 아니었고, 또한 원하는 반응을 얻기 위해 정교한 프롬프트를 사용했습니다.

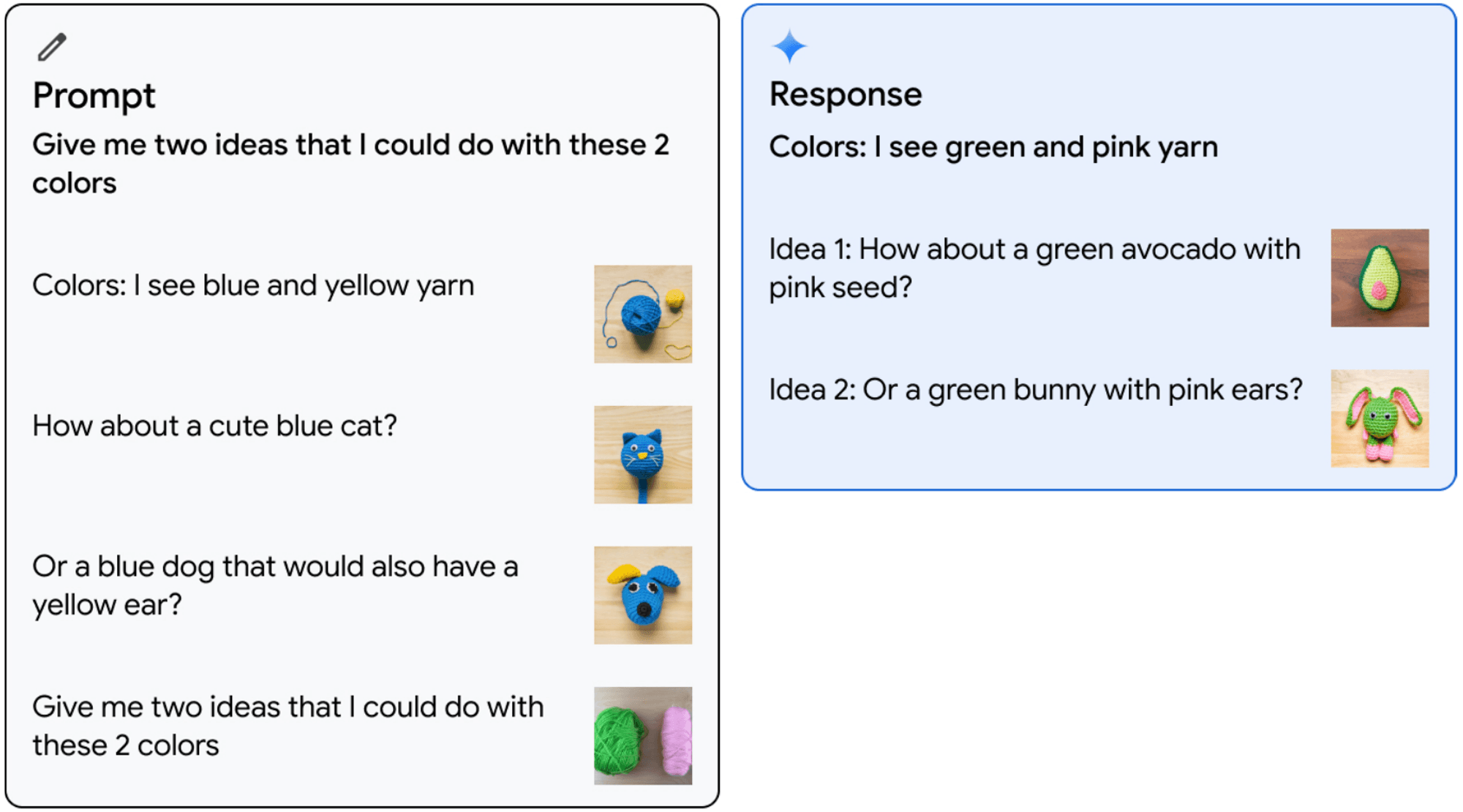

예를 들어 Gemini 소개 영상의 3:39에서 서로 다른 색의 실타래들을 보여주며 그것들로 무엇을 만들지 물어보는 실험은 실제로는 아래처럼 정지된 사진들과 구체적인 응답 예를 가르쳐서 이루어졌고,

Gemini와의 상호작용 예시 4. 문자와 그림이 혼합된 형태로 뜨게질의 아이디어를 제공하고 있다 [Google, Gemini technical report, 2023].

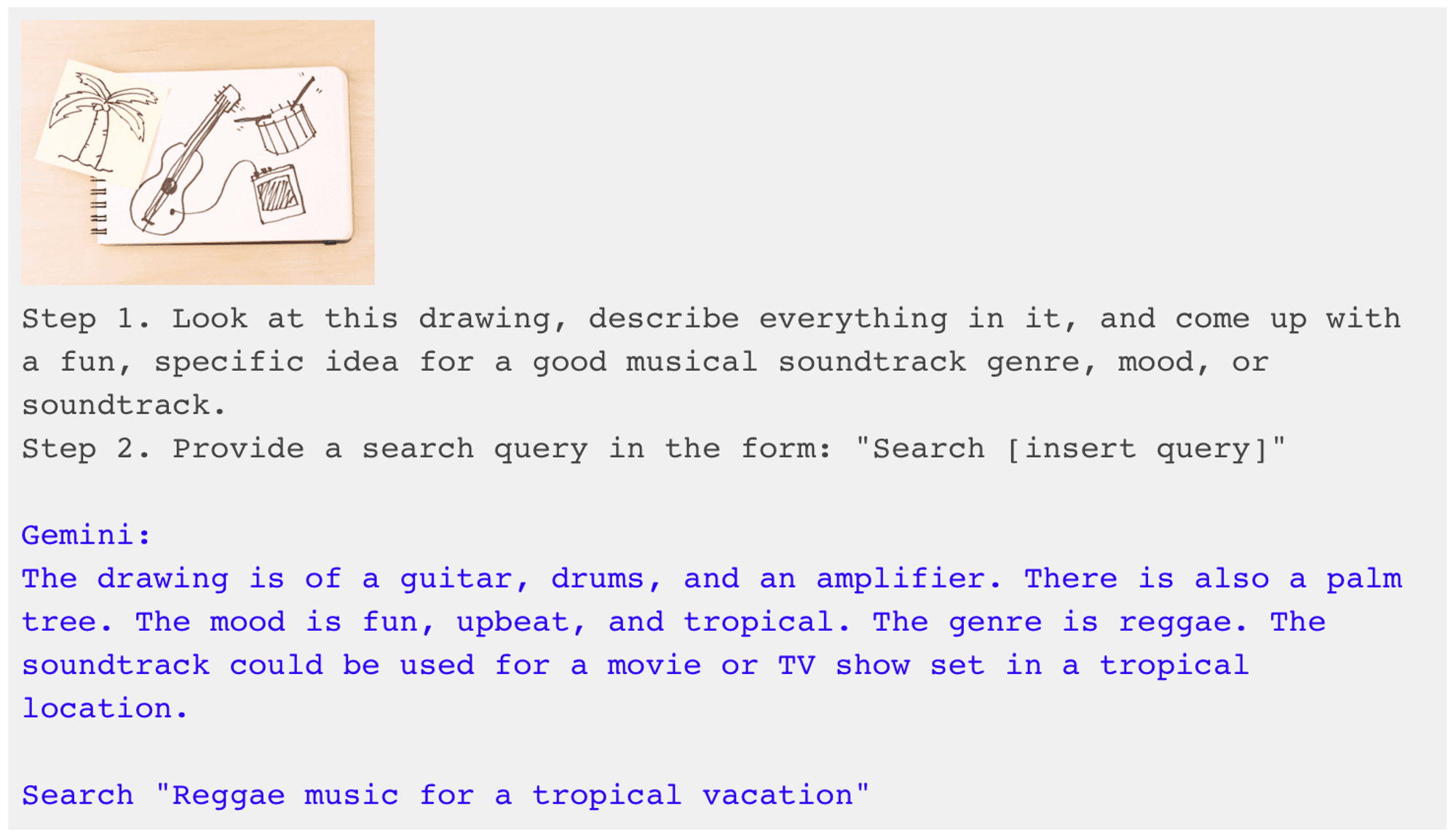

영상의 4:55에서 사용자가 악기들을 그려주니, Gemini가 그에 맞는 음악을 틀어주고 장르를 설명해주는 장면이 나옵니다. 특히 Gemini의 출력이 문자와 그림만 가능하다는 점을 고려할 때, 영상에서처럼 음악 생성까지 알아서 해주진 않았을 거라고 짐작할 수 있죠.

Gemini와의 상호작용 예시 5. 그림에 어울리는 음악 장르와 관련 검색어를 추천받고 있다 [Google, Gemini technical report, 2023].

하지만 저는 이 정도의 속임수가 Gemini의 성능과 가능성을 크게 부풀리고 있다고는 생각하지 않습니다. Google이 홍보 목적의 영상 편집을 한 점은 아쉬운 일이나, 그럼에도 불구하고 보고된 벤치마크 성능들은 사실이며, 연출된 실험 과정과 결과도 여전히 Gemini가 서로 다른 모드를 아우르며 이해와 추론을 하는 놀라운 능력을 보여주고 있습니다.

Gemini 영상의 조작에 관한 기사를 읽고 “역시 사기네,” “아직은 ChatGPT가 답이다”처럼 속단하기보다는, Gemini의 기능을 조금은 자세히 이해해서 나의 일상과 업무에 어떻게 활용할 수 있을지를 고민해보는 건 어떨까요?

Gemini 신약 개발 분야에 적용한다면?

그렇다면 위와 같은 Gemini의 놀라운 능력들이 과연 신약 개발이라는 어려운 문제에도 실질적인 도움을 줄 수 있을까요?

여기에는 Gemini의 예측과 생성의 정확도뿐 아니라 Gemini를 활용하는 방법, 즉 사용자의 활용 역량도 중요할 것입니다. 이미 ChatGPT와 같은 생성형 인공지능에게서 원하는 결과를 얻어내기 위한, 이른바 프롬프트 엔지니어링(prompt engineering)이 일반 사용자뿐만 아니라 학계에서도 활발히 논의되고 있지요.

예를 들어, 논문 PDF를 업로드 해서 요약시키거나, 데이터 시트를 업로드 해서 간단한 분석을 의뢰하는 건 ChatGPT로도 이미 가능한 일이지요. Gemini는 멀티모달리티가 강화된 만큼 우리가 질문할 수 있는 형태도 더욱 다채로워질 텐데요.

그렇다면 신약 개발 업무에 Gemini를 어떻게 활용할 수 있을가요? 아래처럼 이용해보는 건 어떨까요?

-

단백질–화합물 복합체의 3차원 구조를 입력하고, 화합물의 최적화 아이디어를 2차원 그림으로 제안받기.

-

특정한 유도체들의 구조와 물성·활성에 대한 실험 결과를 입력하고, 해당 데이터로부터 유도되는 structure–activity relationship(SAR)을 차트 형태로 분석 받기.

-

화합물 그림과 명칭을 일일이 파악하기 힘든 특허명세서를 입력하고, 내가 궁금한 화합물 구조가 청구항에 포함되는지 판단 받기.

-

새로운 약물 타겟을 선정하기 위해 특정 질환에 대한 연구 결과를 수집시키거나 데이터 출처를 제안 받고, 수집한 데이터를 분석하여 개발 가능성에 대한 의견 받기.

-

화합물의 구조를 입력하여 합성 경로와 수율, 비용, 조건, 전구체 정보 등을 제공받기.

마치며 - AI로 바뀌는 미래

위 [Gemini 신약 개발 분야에 적용한다면?] 에서 제시한 활용 방법들을 보시고 "저런 게 도움이 되겠어?" "저런 게 가능하겠어?"라고 생각하실 수도 있습니다. 물론, 그 같은 아이디어들이 가능할지는 Gemini가 공개적으로 사용 가능해지고, 많은 사용자들의 시도와 검증을 거치는 시간이 필요할 것입니다.

하지만 이미 Google은 애플리케이션 개발을 위한 Gemini Pro의 API를 공개했고, Pixel 8 Pro 스마트폰에 Gemini Nano를 탑재하여 녹음 요약, 사진·영상 보정 등에 쓰는 등 Gemini의 제품화를 본격적으로 시작하고 있습니다.

또한 비록 Gemini와의 직접적 관련은 없을 수 있지만, Google은 최근 단백질–비단백질 결합 구조 예측 (2023.8), 날씨 예측 (2023.11), 무기 소재 발굴 (2023.11), 미해결 수학 문제의 더 나은 답 찾기 (2023.12)처럼 어려운 과학 분야에서 선도적인 성과를 발표하고 있지요.

과학계의 난제를 푼 Google의 성과가 궁금하시다면, 지난 포스팅(AI 신약 개발 공부, 이 논문 3개로 시작하세요 )을 참고 부탁드립니다.

Google의 이런 놀라운 성과들과 2021년 Isomorphic Labs의 출범을 볼 때, Gemini의 개발로 현재로는 상상할 수 없는 혁신이 신약 개발 분야에서도 조만간 등장하는 것은 아닐까요? 오늘 자고 일어나면 내일은 또 무슨 놀라운 기사를 보게 될지 기대됩니다.